반응형

ObamaNet: Photo realistic lip sync from text

Submit : Rithesh Kumar, Jose Sotelo, Kundan Kumar, Alexandre de Brebisson, Yoshua Bengio. arxiv(2017)

Paper : https://arxiv.org/abs/1801.01442

Code : https://github.com/acvictor/Obama-Lip-Sync

0. Abstract

- text, audio -> video : higher dimensional signal

- lip motion에 대한 문제가 있다 -> 입 주의 부분을 어떻게 싱크로맞추냐

- 얼굴의 다른 부분 (눈, 머리, 윗입술, 백그라운드) 를 원래 있었던 비디오의 footage에서 풀려고 함

- 오바마 비디오의 특징은 대통령 연설 부분이 있기 떄문에 컨트롤 된 환경에서 녹화된 것.

- 일반적인 유투브 비디오가 아니고 사람이 비디오의 한 가운데만 있음

1. Introduction

- input, output

- 인풋: 텍스트

- 아웃풋: 비디오

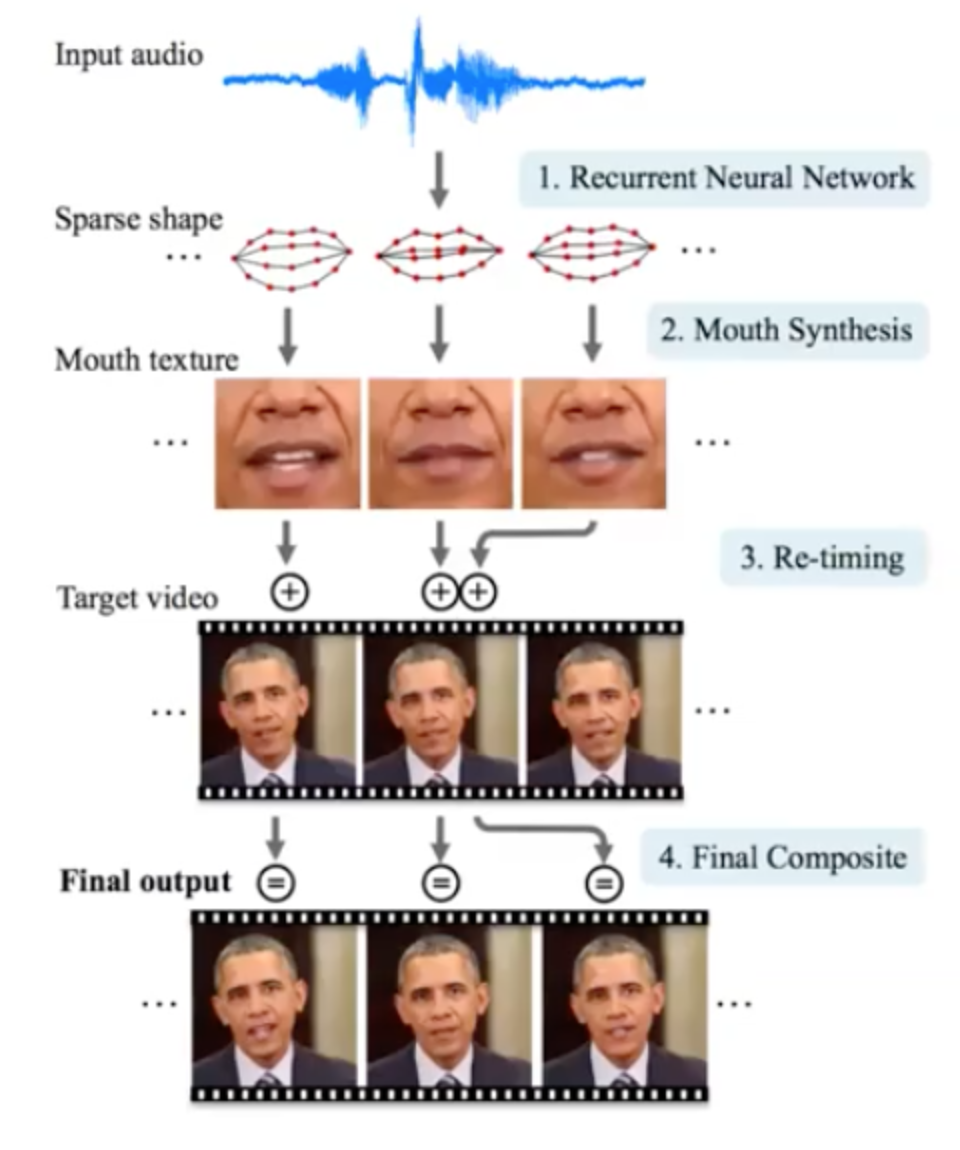

- 3 모듈로 분리

01 텍스트로부터 오디오로 변환

- 텍스트->스피치: 저자들의 다른 모델인 Char2Wav 사용

02 오디오로부터 keypoint로 변환 (입 주변)

- Time-Delayed LSTM 사용

03 keypoints에서 비디오 프레임으로 generate

- pix2pix 네트워크를 사용해서 비디오를 생성하도록 함

- 이 논문의 특별한 점 : 각각의 모듈이 학습가능한 뉴럴 네트워크로 되어있음

- 02, 03에 초점 (01도 중요하지만 text2speech는 다른데서 하는게 낫다.. 너무 할게많음??)

- synthesizing obama : learning Lip Sync from Audio (2017)

2. Method

(1) Keypoint generation

- input: audio features

- vocoder frames extracted from 16kHz audio

- WORLD vocoder 사용

- output: mouth shape representation

- 각 프레임 비디오에서, 모든 포인트를 사용하는건 아니고 프레임을 캡쳐한 다음에 각각의 프레임에서 68 마우스 키포인트를 추출 (dlib사용)

- normalizations

- face location: mean normalization

- face rotation (in-plane): projection into a horizontal axis

- face size: 68 vectors의 norm을 구하고 그걸로 나눠줌

- Apply PCA

- reduce dimensionality and decorrelate the 20 normalizaed keypoints (40-D vector)

- PCA의 첫 5 coefficients 를 캡쳐 > 98% variability

- flow자체는 이전 논문과 비슷

- network: time-delay LSTM (see next slide)

- time delayed LSTM?

- 무언가를 말하기 전에 입이 먼저 말하는 것 ex) uhhh에서 오바마는 이미 입이 열려있다

- 그래서 future context를 더해줘야 한다

- output을 time delay해도 이 어플리케이션에서는 어느정도 됨

- time delayed LSTM?

(2) video generation

- input

- 아래 그림과 같이 인풋,아웃풋 페어가 있다

- 얼굴 이미지가 있고 거기서 입 부분을 크롭 (bbox사용)

- 대신 크롭한데다가 opencv로 아웃라인에 그림

- output

- complete face image with in-painted mouth area

- 나중에 입부분이 generation되면 normalization부분이 있음. 거길 de-normalization이 되어야 타겟과 스케일이 잘 맞음.

- 네트워크: pix2pix

- l1 loss만 해도 충분

반응형

'Paper review > Vision' 카테고리의 다른 글

| [논문 리뷰] Conditional Generative Adversarial Nets (0) | 2020.11.22 |

|---|---|

| [논문 리뷰] Learning Spatiotemporal Features with 3D Convolutional Networks (0) | 2020.06.14 |

| [논문 리뷰] Everybody Dance Now (0) | 2020.06.14 |

| [논문 리뷰] Quo Vadis, Action Recognition? A New Model and the Kinetics Dataset (0) | 2020.06.14 |

| [논문 리뷰] Adversarial Examples Are Not Bugs, They Are Features (0) | 2020.06.14 |