반응형

- submit: Ilyas, Andrew, et al., NIPS (2019)

- paper: https://arxiv.org/abs/1905.02175

1. introduction

- adversarial examples

- deep learning network는 조잡한 perturbation에 취약

- ex) 돼지 -> 91돼지 / 돼지+노이즈 -> 비행기

- adversarial attacks exist?

- model approach

- boundary tilting: 모델이 오버피팅되었기 때문에 boundary에 있는 데이터에 대해선 잘 동작하지 않음

- local linearity: ReLU가 0 이상인 값에 대해선 linearity를 가지고 있음.

- data approach

- 이미지 앞에는 이미 로버스트하지 않은 데이터가 존재.

- model approach

- deep learning network는 조잡한 perturbation에 취약

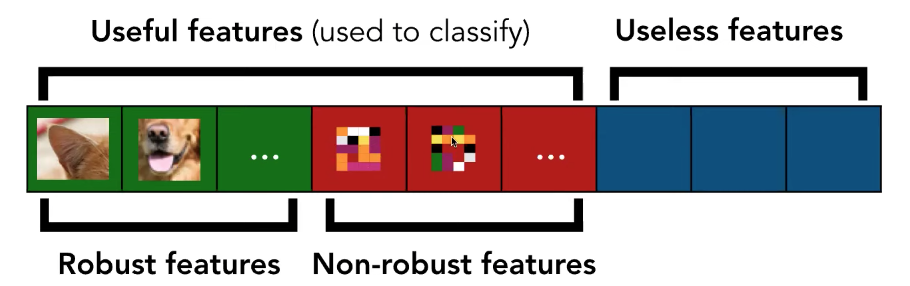

- classifier 학습하면 하나의 클래스에 대해 클래스를 분류하기 위해 유용한 피쳐와 그렇지 않은 피쳐가 존재

- useless feature가 activation되기 때문에 adversarial attack된다는 주장도 있으나, 이 논문에서는 이러한 접근이 잘못되었다고 함.

- adversarial transferability

- 다른 모델, 다른 데이터셋을 줘도 adversarial attacks를 줄 수 있다 : adversarial transferability

2. Method

(a) The robust features model

- mislabeled에 대해 분류하고 원래 데이터셋에 대해 학습하면 제대로 나오는 상황

- robust/non-robust

- robust feature : 사람이 인지할 수 있는 피쳐

- non-robust feature : 인지할 때 이해할 수는 없지만 useful feature

- robust 한 feature만 select하도록 트레이닝

(b) finding robust features

- label과 feature과의 상관관계가 절댓값 기준 일정 기준 이상이면 useful, 아니면 useless feature로 보았다.

- 데이터 안의 피쳐가 오직 robust feature가 useful하다면 일반적인 트레이닝 결과는 robust한 분류

- 데이터 안의 피쳐가 오직 non-robust가 useful하다면 일반적인 트레이닝 결과는 non-robust한 분류

3. Experiments

- 데이터셋

- D: 원래 이미지

- D_R: robust useful feature만으로 생성한 이미지

- D_NR: non-robust useful feature만으로 생성한 이미지

- 결과

- non-robust feature만으로 생성한 이미지를 이용해, 일반적인 training을 하더라도 standard image의 accuracy는 높았음.

- 즉, 우리가 딥러닝 모델에 사용하는 feature 중에는 non-robust useful feature도 포함되어 있음을 알 수 있다.

4. conclusion

- 이미지 안에는 이미 robust뿐만 아니라 non-robust feature가 존재

- 그렇게되면 ML model은 intuitive feature, unintuitive feature를 사용할 수 있음

- 사람이 봤을 때 직관적인 피쳐가 존재할 수 있는데 그렇지 않은 것도 있음

- ml에선 robust useful feature 뿐만 아니라, 사람이 인지할 수 없는 non-robust useful feature도 사용하여 학습을 한다.

- 그러므로 adversarial attack에 취약 -> 즉 모델이 아니고 데이터에 문제가 있다

반응형

'Paper review > Vision' 카테고리의 다른 글

| [논문 리뷰] Everybody Dance Now (0) | 2020.06.14 |

|---|---|

| [논문 리뷰] Quo Vadis, Action Recognition? A New Model and the Kinetics Dataset (0) | 2020.06.14 |

| [논문 리뷰] A Closer Look at Few shot Classification (0) | 2020.06.14 |

| [논문 리뷰] Fast R-CNN (0) | 2020.05.24 |

| [논문 리뷰] You Only Look Once: Unified, Real-Time Object Detection (0) | 2020.05.24 |